前言

Intel OpenVINO 工具組 (本文後簡稱 OpenVINO 或 OV) 從 2022 迎來最大幅度改版,本文將為您介紹 2022.3 LTS 的特色,相關資料擷取自 OV 原廠網站並參閱相關資料 (皆已附上相關連結)。歡迎有興趣導入深度學習應用以及加速開發流程的師長朋友們參考本文。

工具組 (本文後簡稱 OpenVINO 或 OV) 從 2022 迎來最大幅度改版,本文將為您介紹 2022.3 LTS 的特色,相關資料擷取自 OV 原廠網站並參閱相關資料 (皆已附上相關連結)。歡迎有興趣導入深度學習應用以及加速開發流程的師長朋友們參考本文。

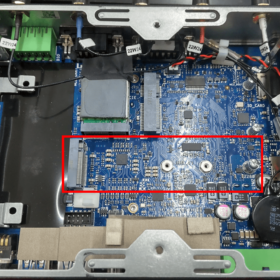

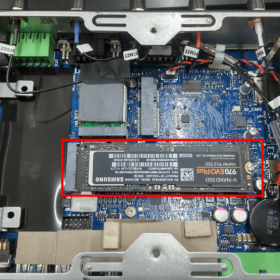

CAVEDU 已為您挑選合適的 NUC,並安裝好 OpenVINO 所需的相關套件,開機就開工! (點我購買)

本文

Intel OpenVINO 工具組 (本文後簡稱 OpenVINO 或 OV) 從 2022 迎來最大幅度改版,目前最新的版本為 2022.3 LTS,標榜效能更好、更多立即可用的模型、裝置可攜性更好,以及用更少幅度的程式碼修改做到更好的推論效能。

工具組 (本文後簡稱 OpenVINO 或 OV) 從 2022 迎來最大幅度改版,目前最新的版本為 2022.3 LTS,標榜效能更好、更多立即可用的模型、裝置可攜性更好,以及用更少幅度的程式碼修改做到更好的推論效能。

CAVEDU 怎麼看 OpenVINO

AI 即工具/服務 (AI as a tool / service) 走到現在的 AI 即產品 (AI as a product),這股趨勢從 NVIDIA TAO toolkit 與 Intel OpenVINO 是非常明顯的。而 Intel OpenVINO 自從 2018 公布以來,希望讓開發者不須具備太多的專業知識,就能根據您的使用案例來部署最合適且最佳化的 AI 解決方案。

就白話一點的角度來說,除非我的工作目標就是要訓練出一款更棒神經網路模型,否則絕大多數人的目標應該都是 “如何找到一款最適合我的神經網路來快速解決我所碰到的問題“。CAVEDU 從 2019 年接觸 OpenVINO 以來 (相關文章請點我),也累積了不少使用心得,相信 OpenVINO 2022 可以更快更好地滿足您各方面的開發需求,所提供的教學方案也很適合學校教學使用。

CAVEDU 已為您挑選合適的 NUC,並安裝好 OpenVINO 所需的相關套件,開機就開工! (點我購買)

透過 OpenvINO 全面掌握並充分運用您的 AI 部署計畫

OpenVINO 可讓您對幾乎是所有框架所建置的深度學習模型進行最佳化,並將其部署在一系列 Intel 處理器與其他硬體平台上,當然,效能也是一等一。OpenVINO 工作流程如下,簡單分為建模(model)、最佳化(optimization)與部署(deployment),每個步驟在實務上都有非常多要考量的面向,可說是牽一髮動全身,因此才需要 OpenVINO 這類工具組為開發者提供許多好用的解決方案來加速開發。

OpenVINO 工具組讓程式碼改寫與維護變得更簡單。藉由 Open Model Zoo 所提供的最佳化預訓練模型與 Model Optimizer API,讓您的模型在轉換與用於推論上變得更得心應手。執行階段 (又稱推論引擎) 可進一步編譯已最佳化網路與管理不同裝置上的推論作業來進一步提升效能。它還針對 CPU、GPU平台提供了裝置探索(device discovery)、負載平衡(load balancing)與推論平行化(inferencing parallelism) 等諸多方案供開發者使用。

除此之外,OV 也標榜與更多裝置、平台有更好的整合結果,如下圖 (期待每一版本都能整合更多~):

2022.3 LTS 有哪些重大改變?

以下僅列出大標題,詳細 release 內容請參考 OV 原廠文件:

- 更廣泛的模型與硬體支援 – 在包括 NLP 在內的廣泛深度學習模型上輕鬆優化與部署,並在廣泛的硬體上存取 AI 加速。

- 擴大模型涵蓋範圍 – 在廣泛的深度學習模型上輕鬆優化與部署。

- 改善 API 與更多整合 ──更容易採用與維護程式碼。需要更少的程式碼變更、更符合框架,並且最小化轉換

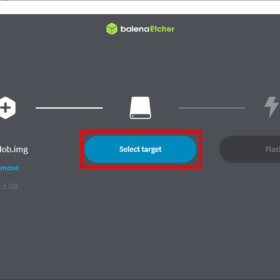

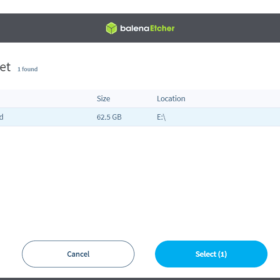

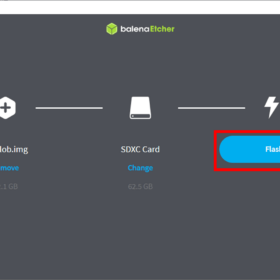

如何開始

OV 支援了不同環境、作業系統、版本、安裝方式與框架,請由本頁面選擇您喜歡的起點開始吧

您也可以直接從 Intel® Developer Cloud 來試試看,其中已經預先安裝好了各種最佳化框架、工具與函式庫,讓您可以立即體驗 OpenVINO 與 oneAPI。

OpenVINO model zoo

想了解 OV 有哪些立即可用方案的話,請參考 OpenVINO model zoo (原廠簡稱 OMZ),當然也要看看他所提供的各種 demo case 來挑選適合您的解決方案。OMZ 免費提供了數十款的預訓練深度訓練模型與應用案例,您可運用現成的樣板來加速完成您的深度學習專案,支援語言包括 Python 、C++ 與 OpenCV Graph API (G-API)。

OV 也針對 Python 開發者提供了 Google colab 實作,直接點選 Tutorial 頁面中各範例旁的 colab icon 就可以直接在,無須安裝任何東西即可馬上體驗許多有趣的範例,包括影像分類、認識 OV Python API、影像分割與文字偵測等等諸多實用的功能。

Intel Edge AI Certification Program

學習腳步可不能停!歡迎從 Intel Edge AI Certification Program 來免費學習更多關於邊緣運算與 AI 的相關知識,除了 AI 與邊緣運算的發展與必要性之外,您也會使用 OpenVINO 框架來進行模型最佳化以及運行於不同平台上所需的實務經驗,本計畫已提供了非常豐富的教學影片與對應的範例專案,有中文解說,快點來看看吧。

完成課程之後即可進一步取得 Intel certified Edge AI Developer 徽章,如果要取得認證徽章的話,需另外付費

參考資料

註:本文圖片皆引用自 Intel OpenVINO 網站

〈Intel OpenVINO™工具組 2022.3 LTS 有什麼?〉這篇文章最早發佈於《CAVEDU教育團隊技術部落格》。